[論文紹介] 脳の言語処理と様々なニューラルネットワークモデル

最終更新日: 2020年8月24日今回は『Artificial Neural Networks Accurately Predict Language Processing in the Brain』という論文の紹介をしたいと思います。

論文: bioRxiv Link

Talk: Webinar Link

この論文はプレプリントであり、ピアレビューによる保証はありません (2020/08/24)

Computational neuroscience has lately had great success at modeling perception with ANNs - but it has been unclear if this approach translates to higher cognitive systems. We made some exciting progress in modeling human language processing https://t.co/QVdMVbRvdX #tweeprint 1/ pic.twitter.com/SdaiQ1GNte

— Martin Schrimpf (@martin_schrimpf) June 27, 2020

Abstract

- SOTAなニューラルネットワークモデルが、人間の神経活動を説明できるかどうかを調査しました。

- 複数のモデル・データセットを用いて、最も強力な生成変換モデルが神経活動をよく予測することを発見しました。

- モデルの予測性は全てのデータセットで一貫しており、モデルの特徴や構造との対応関係に興味深い点を発見しました。

Introduction

文章を読むとき、我々の脳は複雑で構造化された意味表現を文章から取り出しています。この処理は、言語的な入力に応答性のある、左の前頭側頭ネットワークに依存しているとされています。

しかし、脳内の言語処理計算は未だ正確にはわかっていません。文章構造をほぼ正確に説明するモデルによっても、脳の神経活動は説明しきれていないのです。

最近、非常に大きな言語データセットで学習した人工神経回路網(ANN; ニューラルネットワーク)は、汎用的な言語機能をもつことが分かってきました。BERTやGPTが有名でしょう。では、これらの ANN によって脳内の言語処理計算を明らかにすることはできるのでしょうか?

初期の研究1では、複数のモデルと単一データセットによる実験によって、いくつかのモデルの説明性が高いということを示しました。そこで、この研究では 43 個の ANN モデルと 3 つの言語処理の神経活動データセットを用いて次の 4 つの基本的な質問に対処しています。

- どのモデルが神経活動を最もよく説明するか?

- 単語予測で学習したモデルが最もよいのか?

- 最もよく神経活動を説明するモデルが、人間の行動特性も説明するか?

- モデル構造と学習規則と神経活動の説明性との関連は?

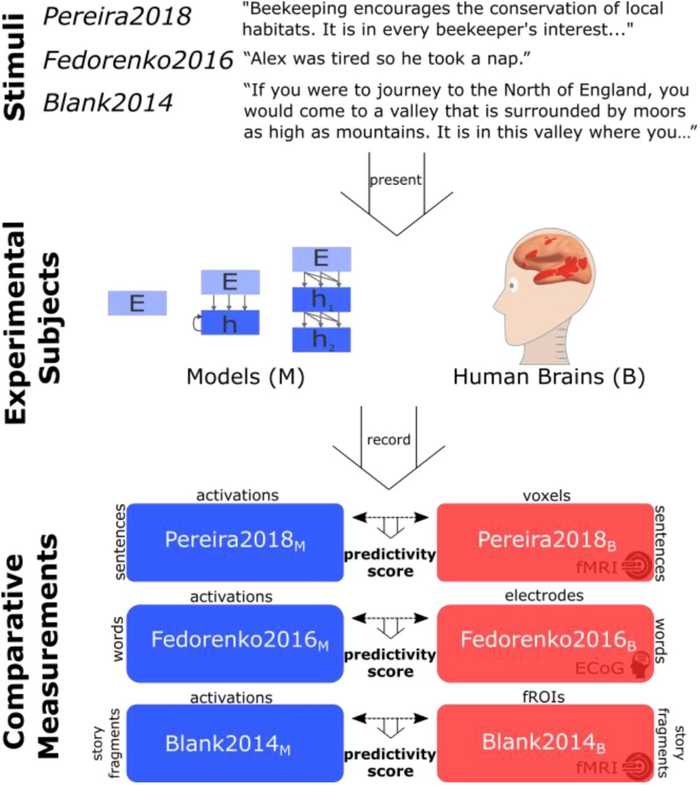

(Schrimpf et al. (2020) より引用)

Results

3つのヒト神経活動データセットについて、SOTAなANNモデルとの表現の共通性を調べました。これらは、データ取得法、刺激の単位、刺激モダリティーが異なります。

- Pereira 2018

- Pereira et al. (2018)

- fMRI データ

- 多様なトピックの短いパッセージを読解する。

- Fedorenko 2016

- Fedorenko et al. (2016)

- ECoG (Electro-Cortico-Grpahy) データ

- 意味・構文的に多様な文章を、1単語ずつ読む。

- Blank 2014

- Blank et al. (2014)

- fMRI データ

- 数分の長い自然な物話を聴く。

自然言語ANNモデルとしては

- 埋め込みモデル (GloVe)

- 再起型ニューラルネットワーク (LM1B)

- 注意ベースのニューラルネットワーク (BERT, XLM, GPT, T5)

を利用しました。

言語処理に注目するため、Pereira 2018 をベースとして分析を始めました。このデータセットでは、文章の読み取りと非単語処理との対比が行われています。

ANNモデルに文章を与えたときの活性化を記録し、それによる神経活動の予測性を測定しました2。結果として、図2bにみられるような前頭側頭ネットワーク (fronto-temporal network) が検出されました。

(Schrimpf et al. (2020) より引用)

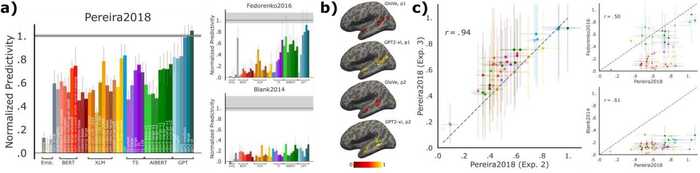

モデルの予測性

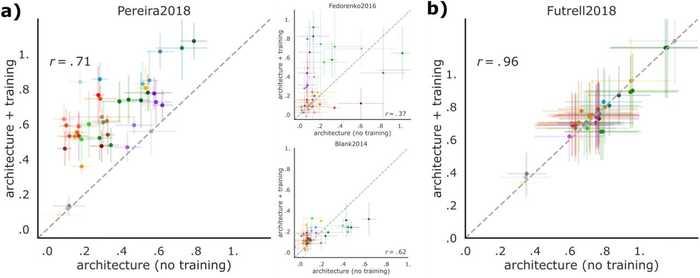

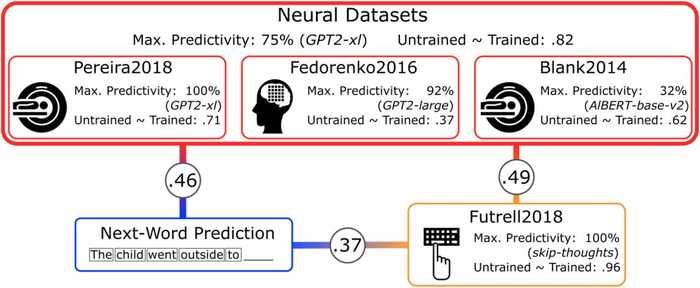

モデルの予測性について比較しました。埋め込みモデルは、どのデータセットでも上手く機能しませんでした。一方、再帰型ニューラルネットワークや注意ベースのニューラルネットワークは、高い予測性を示しました。特に、GPT2-xl が最高の予測性を示しました。

モデルのスコアの一貫性から、汎化性能を調査しました。図2cを見ると、データセット間におけるスコアに相関性があると分かります。つまり、あるデータセットで予測性が高いモデルは、他のデータセットにおいても予測性が高い傾向にあるわけです。

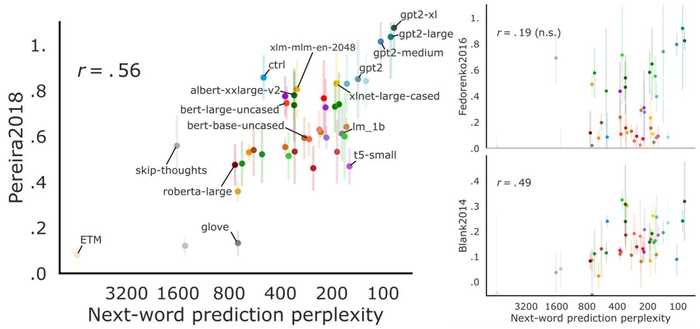

Next-word-prediction の性能と神経予測性能

言語処理における予測の重要性や、次の単語の予測タスクと人間の行動の類似性が示唆されてきました。ここでは、Wikitext-2 データセットの単語予測精度と神経活動の予測性の関係を調べました。

結果として、次の単語の予測精度と、神経活動の予測性には相関関係 (r=0.45, p<0.01) がありました。この傾向は、モデルの構造に関係なく存在しました。したがって、次の単語を予測するタスクは脳内表象へ当てはめるために重要であるといえます。

(Schrimpf et al. (2020) より引用)

一方、より抽象的な言語タスクの指標であるGLUEベンチマークは神経活動の予測性との相関関係がありませんでした。これは、Gauthier & Levy, (2019) と一致し、予測表現の最適化が脳とANNの共通の目標であると考えられています。

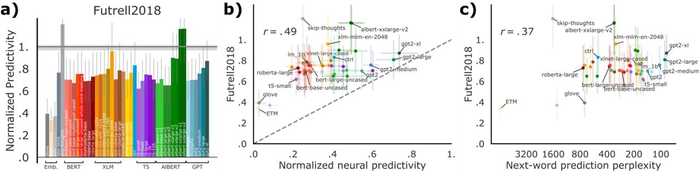

行動の予測性との関連

Futrell 2018 における単語ごとの読解時間と、ANNモデルとの関連を調べました。これは、行動学的特性における文章理解の計算モデルとしての妥当性を調査しています。

結果として、神経活動と同様に、GPT2-xl や skip-thoughts、AlBERT-xxlarge といったモデルが、高い行動の予測性を示しました。

(Schrimpf et al. (2020) より引用)

さらに、神経活動の予測性と行動の予測性にも相関関係が (r=0.49, p<0.001) ありました(図4b)。

モデル構造だけで、予測表現が取得できる

モデルの重みをランダムにした場合の表現について、神経活動の予測性を調べました。ここで、それぞれのモデルは固有の構造を持っていて、最適化させる表現空間に違いが生じています。

結果として、学習前でも神経活動の予測性の高いモデルが存在し、学習後における予測性との相関関係が存在しました。つまり、学習前に予測性の高いモデルほど、学習後の予測性が高くなるということです。

(Schrimpf et al. (2020) より引用)

一方、Fedorenko 2016 や Blank 2014 では、AlBERT や GPT2-xl において学習後に神経活動の予測性が低下するという現象がみられました。

Discussion

この研究では、特定のANNモデルが、言語入力に対するヒトの神経活動と行動を高精度で予測できることを示しました。これは、データ取得法、刺激の単位、刺激モダリティーにわたってロバストでした。

また、次の単語予測精度と、神経活動や行動の予測性とが相関していました。さらに、モデル構造だけで比較的高い予測性を実現できていました。

(Schrimpf et al. (2020) より引用)

ANNは、基本的な言語モデリングタスク(次の単語の予測)によって、様々な言語構造を捉えつつ最適化を行っています。この精度が神経活動の予測性と関連しているため、ヒトも同様に最適化を行って効率的に意味抽出をしている可能性があります。

また、モデル構造だけでよい表現空間を得られていることは、ヒトの皮質が言語の迅速な習得に適した構造を持っている可能性を示唆しています。

これらの発見は、脳に似た言語モデルの調査に繋がります。最小限の構造と学習目的を探すことは、人間の言語処理モデルにおける必要十分条件を探すことに繋がります。しかし、学習の金銭的コストや、構造の影響を完全には排除できないことが問題となります。

どうすればさらに脳に近いモデルを開発できるのでしょうか? 最新の言語モデルでも、主に局所的な構造の情報を使っていて、意味の理解など難易度の高いタスクの性能は低いままです3。ここで重要な方向性は、常識的な意味知識を捉えることができるモデルやデータと統合させることです4。

人間の言語処理のモデリングで欠けている要素のひとつは、モデルから脳への詳細なマッピングです。特に、モデルのどの部分が、言語処理領域のどこにマッピングされるかはわかっていません。また、詳細なマッピングには空間的・時間的な解像度がもっと高くなければならない可能性もあります。しかし、詳細なマッピングは病変の評価やBMIの発展に欠かせないでしょう。

Reference

- Schrimpf, M., Blank, I. A., Tuckute, G., Kauf, C., Hosseini, E. A., Kanwisher, N. G., ... & Fedorenko, E. (2020). Artificial Neural Networks Accurately Predict Language Processing in the Brain. BioRxiv. url

- Pereira, F., Lou, B., Pritchett, B., Ritter, S., Gershman, S. J., Kanwisher, N., ... & Fedorenko, E. (2018). Toward a universal decoder of linguistic meaning from brain activation. Nature communications, 9(1), 1-13. url

- Fedorenko, E., Scott, T. L., Brunner, P., Coon, W. G., Pritchett, B., Schalk, G., & Kanwisher, N. (2016). Neural correlate of the construction of sentence meaning. Proceedings of the National Academy of Sciences, 113(41), E6256-E6262. url

- Blank, I., Kanwisher, N., & Fedorenko, E. (2014). A functional dissociation between language and multiple-demand systems revealed in patterns of BOLD signal fluctuations. Journal of neurophysiology, 112(5), 1105-1118. url

- Schrimpf, M., Kubilius, J., Hong, H., Majaj, N. J., Rajalingham, R., Issa, E. B., ... & Yamins, D. L. (2018). Brain-score: Which artificial neural network for object recognition is most brain-like?. BioRxiv, 407007. url

- Gauthier, J., & Levy, R. (2019). Linking artificial and human neural representations of language. arXiv preprint arXiv:1910.01244. url

- Gauthier & Ivanova (2018); Gauthier & Levy (2019); Hu et al. (2020); Jain & Huth (2018); Wang et al. (2020) が挙げられていました。↩

- Schrimpf et al., (2018) などの方法。線形予測モデルを立てて、CV精度をピアソン相関で算出します。さらに、被験者が無限大の場合に設定された天井 ("ceiling") によって値が正規化されました。↩

- これがBlank 2014で上手く機能していない原因の可能性があります。↩

- 例えば、Bisk et al. (2020); Bosselut et al. (2020); Sap et al. (2019); Sap et al. (2020); Yi et al. (2018) があるようです。↩