[論文紹介] 自己教師あり学習法 BYOL

最終更新日: 2020年6月26日今回は『Bootstrap Your Own Latent A New Approach to Self-Supervised Learning』という論文の紹介をしたいと思います。

この論文はプレプリントであり、ピアレビューによる保証はありません (2020/07/11)

論文: arXiv Link

コード: GitHub Link

ベンチマーク: Papers With Code Link

Abstract

- 自己教師ありの画像表現学習 (self-supervised image representation learning) の新しいアプローチ Bootstrap Your Own Latent (BYOL) を提案します。

- 2つのニューラルネットを相互に作用させて同時に学習させます。

- ネガティブペアを使わずに、Top-1 精度 で SOTA 並のパフォーマンスを実現しました。

Introduction

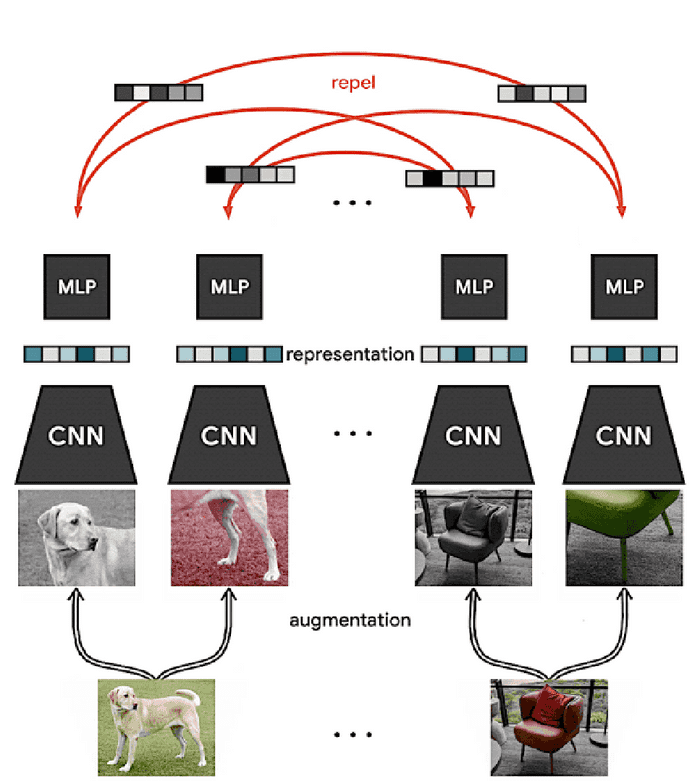

より良い画像表現を学習させることは、転移学習での効率化に繋がります。多くのアプローチが提案されていますが、中でも、同じ画像(ポジティブペア)の画像間の距離を減らし、違う画像(ネガティブペア)間の距離を増やすことによって学習する方法が SOTA となっています(参考:以前の記事(教師なし深層学習と腹側視覚経路)における対照的埋め込み)。この方法では、ネガティブペアの慎重な処理や適切なデータ拡張 (Data Augmentation) によってパフォーマンスが変化します。

この論文では、新しい自己教師ありの画像表現学習 (self-supervised image representation learning) である、Bootstrap Your Own Latent (BYOL) を提案します。反復的にニューラルネットの出力をブートストラップし、拡張表現のターゲットとして用います。表現を直接ブートストラップすることが重要なのです。そのために、オンラインネットワークとターゲットネットワークといった2つのニューラルネットを使用し、相互に作用させて同時に学習させます。

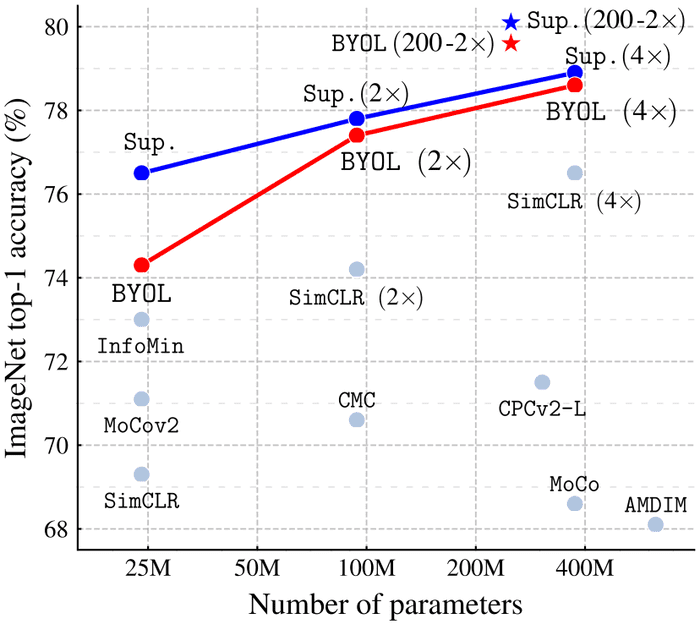

BYOL が ImageNet で学習した表現と ResNet を使用したベンチマークを評価し、Top-1 精度 で 74.3 %、79.6 % を達成しました。この論文の貢献は以下の3点です。

- BYOLの提案。自己教師あり表現学習法で、ネガティブペアを使用せずにSOTAを実現しました。

- 半教師あり学習・転移学習において SOTA 以上の評価を達成しました。

- BYOLが、対照的な埋め込みよりロバストなことを示しました。

Method

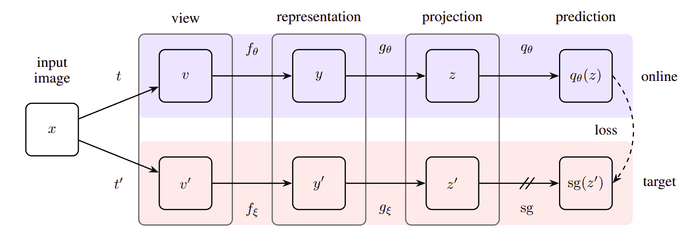

多くの自己教師あり学習は、Cross-view Prediction Framework (Becker and Hinton (1992)) のもとに構築されています。この方法では、同じ画像の違う見かけを互いに予測することで表現を学習します。しかし、違う見かけの画像が表現空間で同じになってしまうことがあります。BYOL では、固定されたネットワークを用いて予測を生成すると表現空間の崩壊を防げることを経験的に示しました。

BYOL の目標は、ダウンストリームタスクで利用できる表現 を学習することです。前述したように、BYOLは2つのニューラルネット(オンラインとターゲット)を利用します。ターゲット(赤)の出力をオンライン(青)に予測させるさせるようにして、自己教師あり学習を行いました。

オンラインは「一貫した重み 」を持っていて、ターゲットは「 の移動平均による重み 」を持っています。したがって、 は以下のように更新します。

画像のデータセット からサンプル が独立に生成し、2つのデータ拡張の分布 が決まっていると仮定します。このとき、 に対し2つの拡張見かけ(変換後画像)を

と定義します。ここで、, です。

したがって、オンラインネットワークについては、

となり、ターゲットネットワークについては、

となります。出力については、以下のようにL2正規化をしておきます。

最後に、2つの出力の平均二乗誤差を を定義します。

次に、データ拡張を入れ替えて、 を定義します。

目的関数は、 となり、 について最小化します。最終的な表現としては、エンコーダー によって取得できます。

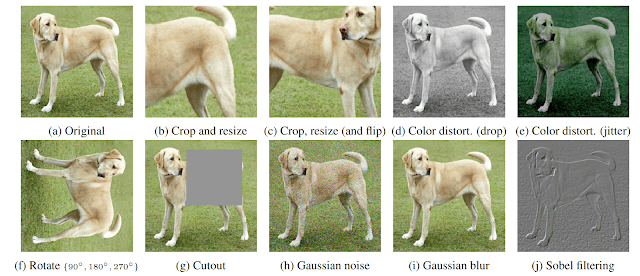

データ拡張

SimCLR (Chen et al. (2020)) と同じデータ拡張手法を使用します。 と では、変換パラメータを変えています。

- ランダム切り抜き (random cropping)

- (任意)左右反転 (left-right flip)

- ランダムな色ずらし (color jittering)

- (任意)グレースケールへの変換 (color dropping)

- ガウシアンノイズ加工 (Gaussian blurring)

- 感光化 (solarization)

モデル構造

ResNet-50 を として利用しました。これをベースラインとして、ResNet-50, 101, 152, 200 (1, 4) も比較しました。SimCLR と同様に、表現 は3層パーセプトロン に入力します。最終的な出力は 256 次元に設定します。

最適化

LARS 最適化法 (You et al. (2017)) に 学習率のコサイン減衰をかけて 1000 エポック以上学習させました。

Results

ImageNet での線形評価

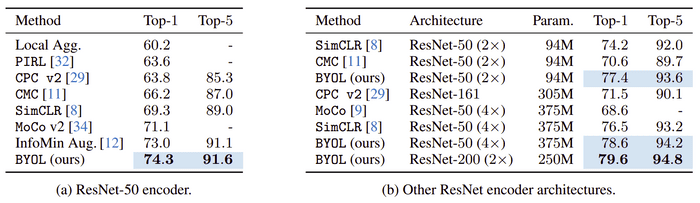

自己教師あり学習で取得した表現を線形分類器にかけたときの精度を評価しました(表1)。自己教師あり学習の他手法と比べると SOTA となりました。また、ResNet-50 (4 ) では、教師ありのベースライン(Gong et al. (2020); MaxUp; 78.9 %)と同程度になりました。

ImageNet での半教師あり学習

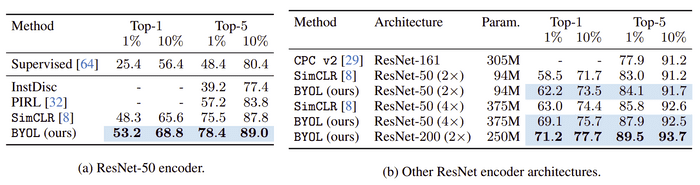

少量のラベルでエンコーダーを転移学習させたときの精度を評価しました(表2)。ここでも、他の手法と比べると SOTA となりました。また、100 % データを使った場合、教師ありのモデルより高精度を達成しました。

他のデータセットへの転移学習

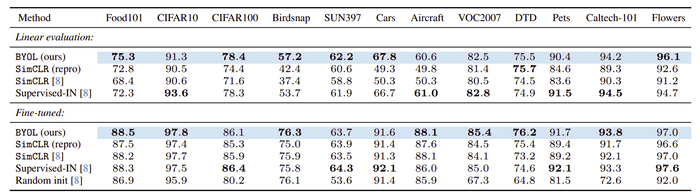

他の画像分類データセットへの転移学習のパフォーマンスを評価しました(表3)。パフォーマンスの評価は、それぞれのデータセットに従いました。全てのデータセットで SimCLR を上回り、12/7のデータセットで教師ありニューラルネットモデルを上回りました。中でも、小さい画像 (CIFAR)、風景 (SUN397、VOC2007)、テクスチャ (DTD) で効果的に転移学習ができました。

他のタスクへの転移学習

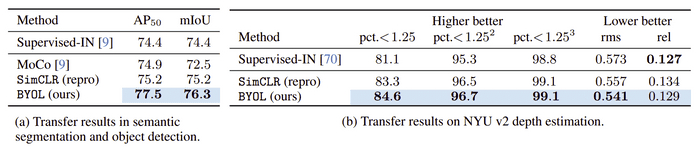

他の視覚タスク(セマンティックセグメンテーション、オブジェクト検出、深度推定)についても、エンコーダーを評価しました(表4)。結果、全てのタスクで SimCLR、教師ありNNモデルを上回りました。

( ablation study は省略します。)

Conclusion

画像の自己教師あり表現学習の新しい手法として、BYOL を提案しました。この手法では、ネガティブペアを利用せずに表現を学習し、様々なベンチマークで SOTA を達成しました。特に、ImageNet の線形評価においては、自己教師あり学習と、通常の教師あり学習とのギャップを埋めることができました。

しかし、BYOL は画像特有のデータ拡張に大きく依存しています。BYOL を他のモダリティのタスクに一般化するには、それぞれに適切なデータ拡張をする必要があります。このような拡張には多大な労力と専門知識が必要になるため、データ拡張の自動的な探索が次に必要となると思われます。

Reference

- Grill, J.-B., Strub, F., Altché, F., Tallec, C., Richemond, P.H., Buchatskaya, E., Doersch, C., Pires, B.A., Guo, Z.D., Azar, M.G., Piot, B., Kavukcuoglu, K., Munos, R., Valko, M., (2020). Bootstrap Your Own Latent: A New Approach to Self-Supervised Learning. arXiv:2006.07733. url

- Becker, S., Hinton, G. Self-organizing neural network that discovers surfaces in random-dot stereograms. Nature 355, 161–163 (1992). url

- Chen, T., Kornblith, S., Norouzi, M., & Hinton, G. (2020). A simple framework for contrastive learning of visual representations. arXiv preprint arXiv:2002.05709. url

- BYOL: Bootstrap Your Own Latent: A New Approach to Self-Supervised Learning (Paper Explained) YouTube Link